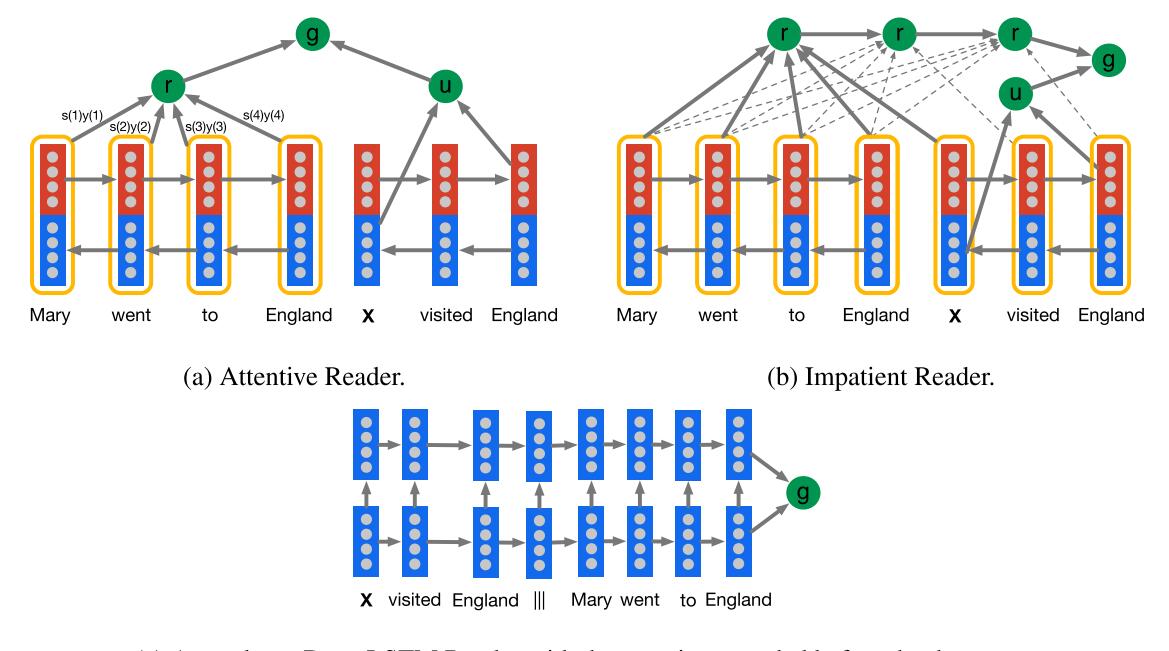

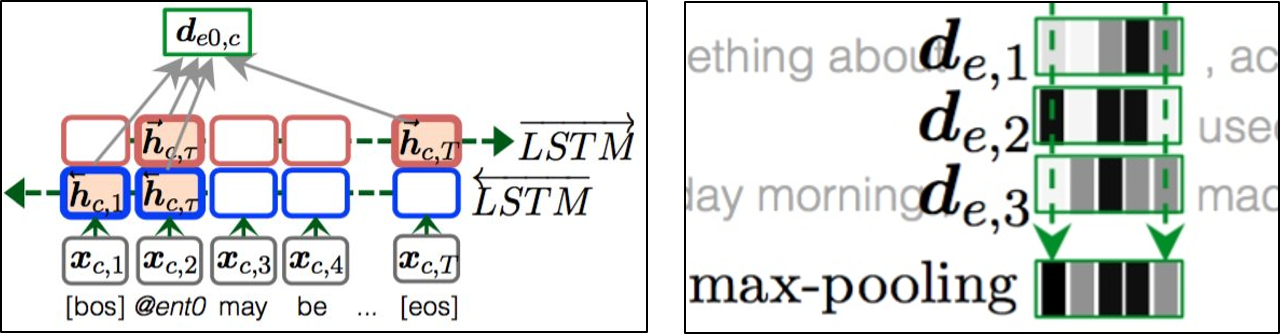

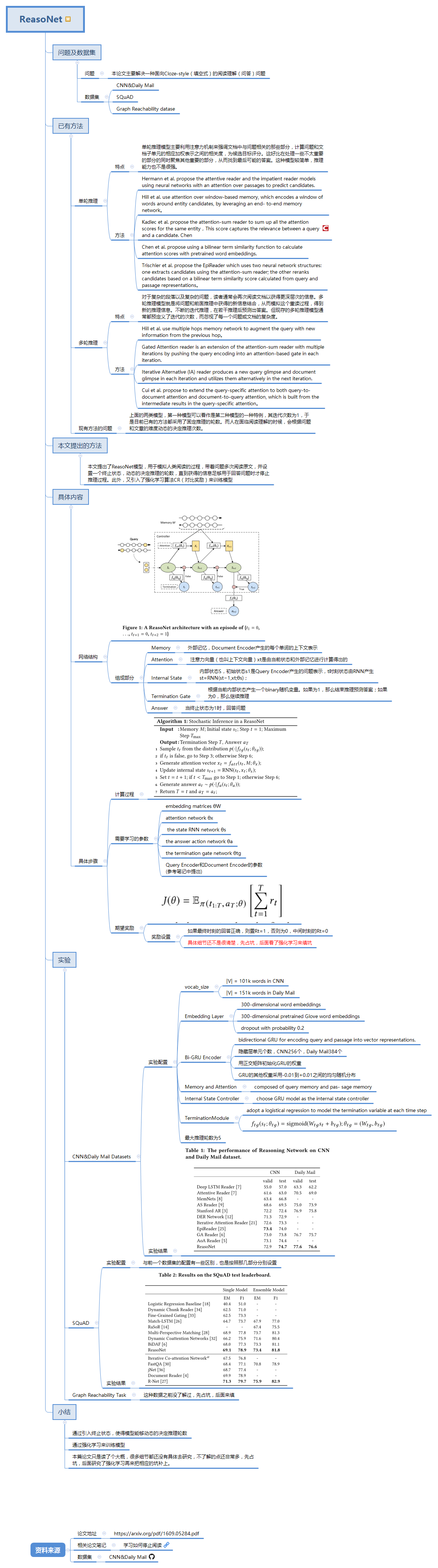

本文主要介绍GA reader模型的基本思想,由论文《Gated-Attention Readers for Text Comprehension》提出,论文直通车

1 论文概述本篇论文的思想其实是很简单的,可以把其看成是AS reader

2019-04-03