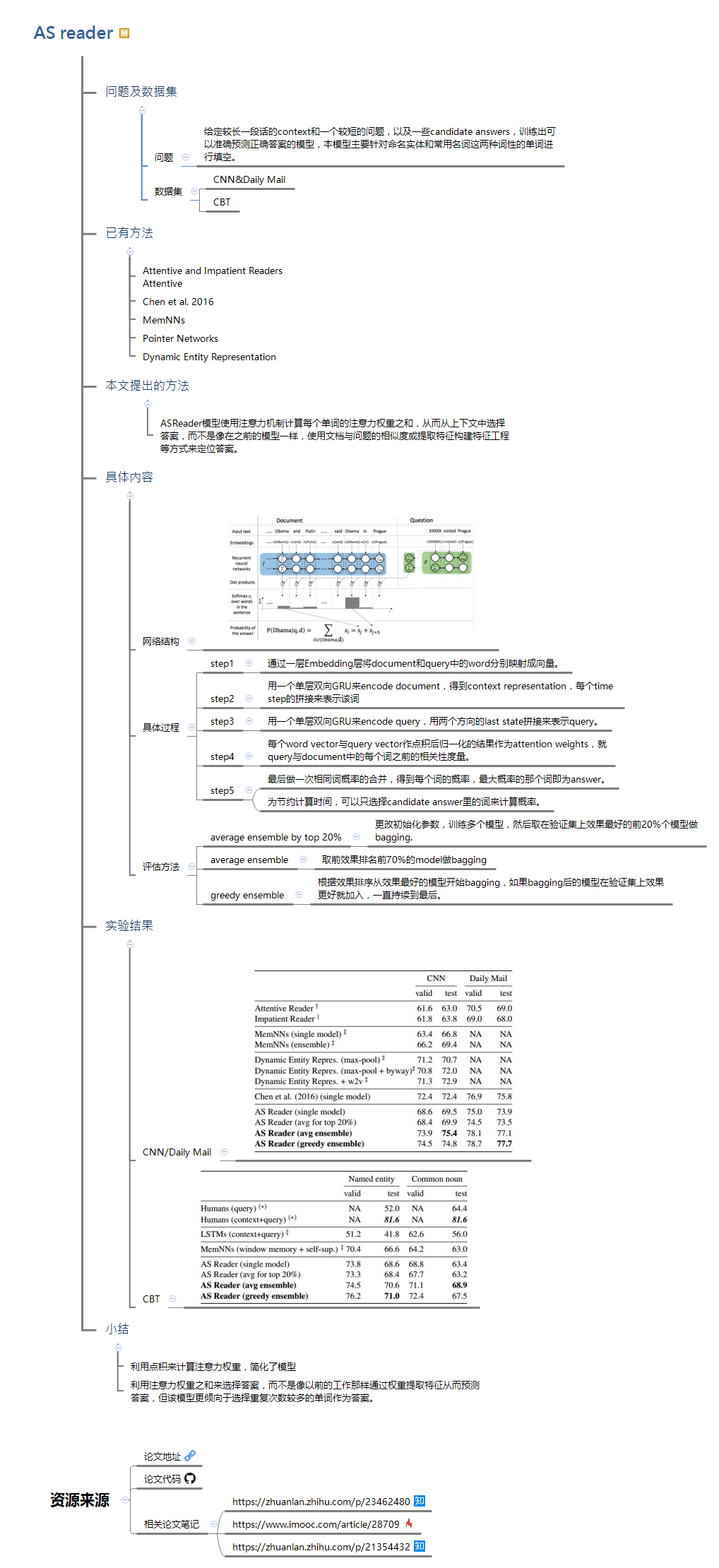

1 问题及数据集1.1 问题给定较长一段话的context和一个较短的问题,以及一些candidate answers,训练出可以准确预测正确答案的模型,本模型主要针对命名实体和常用名词这两种词性的单词进行填空。

1.2数据集(1)CNN&

2018-10-13