(1)论文创新点

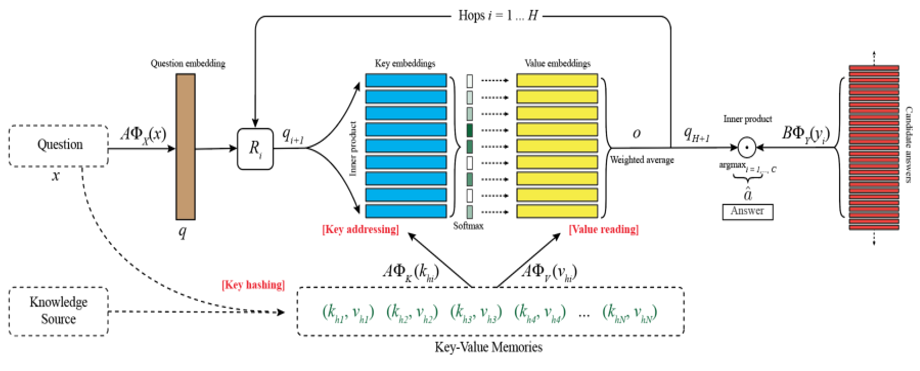

这个模型的文章和问题在真正使用时,都是根据前一时刻的隐层状态,动态的表示成一个向量;

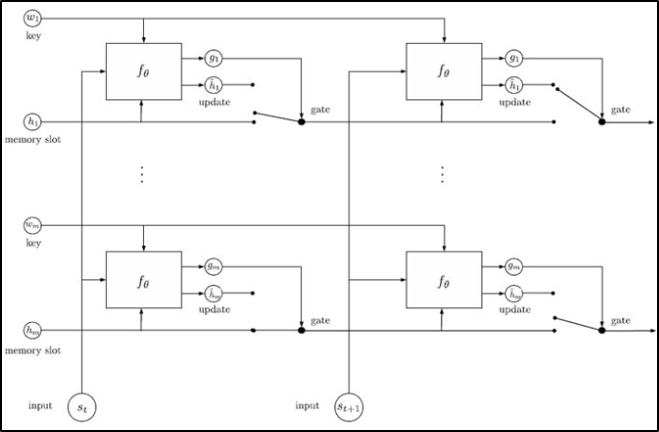

在更新状态时,使用了gated机制(虽然看起来有点复杂)。

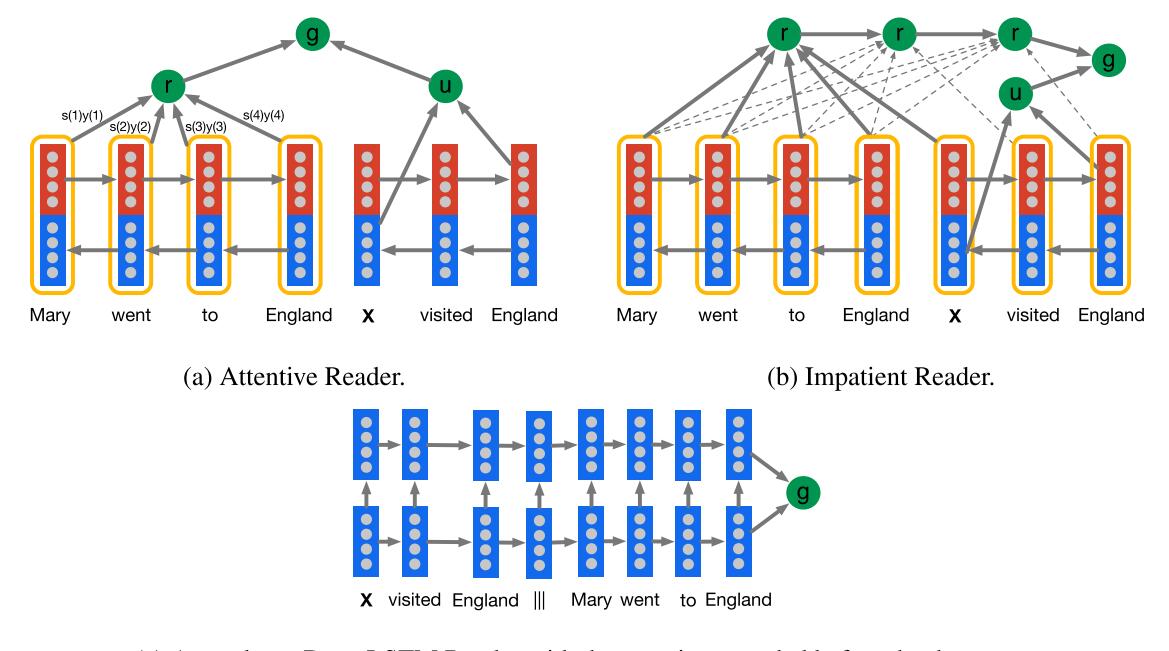

(2)论文模型模型的整体结构图如下所示:接下来将对该模型上的组成部分做简单

2019-03-30